几天前阿里开源了自研的文生视频项目万相 wan2.1,其中 T2V-1.3B 模型仅需 8.19 GB 显存即可运行,并且在性能和质量方面的表现都较为亮眼。作为视频生成领域的新秀,wan2.1 在一定程度上展现出了闭源项目的技术水平。并且由于同时支持中文或英文提示词,使用起来也更加符合国人的习惯。

虽然官方文档里已经对安装部署方法进行了介绍,但对于新手而言还是容易遇到不少坑点。本文我们以 Windows 环境为例详尽说明如何安装部署 wan2.1 。

0.硬件需求

相对而言 wan2.1 的硬件需求并不高,但仍然需要留意:

- CPU:无硬性需求但尽量避免性能太弱

- 内存:建议 64GB 或更高,如低于可使用虚拟内存补足

- 硬盘:最好使用 SSD ,不低于 20GB 空间可用

- 显卡:N卡30系起(如 3080)且显存不低于 10GB

A卡相对较为麻烦,具体可以参考:https://github.com/Dao-AILab/flash-attention

1.安装依赖环境

1.1 Python

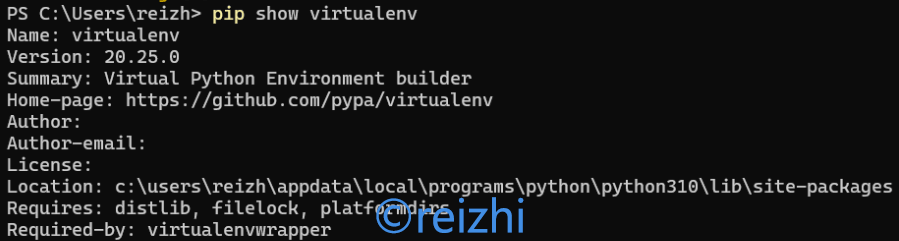

在 Python 官网下载 Windows 平台安装包即可,不低于 3.9 版本都可以。安装完成后,打开一个命令提示符窗口(或者 powershell),运行:pip3 install virtualenv 。

待安装完成后,运行 pip show virtualenv 能够看到版本号即为安装成功。

1.2 Git

Git 主要用于拉取代码,在官网下载安装并使用默认推荐设置即可。安装完成后,在命令提示符窗口切换到想要保存项目的路径,依次执行:

I:

cd AI

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1以上命令的作用是进入 I: 盘的 AI 文件夹(如不存在需要提前创建),拉取万相的代码并进入到代码目录。

1.3 venv

使用 venv 创建一个新的虚拟 Python 环境,避免破坏本机环境。

python3 -m venv venv

cd venv\Scripts

activate.bat

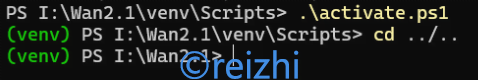

cd ..注意如果使用 powershell 倒数第二步需要换成 .\activate.ps1 ,并且需要提前使用管理员权限更改 set-ExecutionPolicy RemoteSigned 。

一切正常的话命令提示符最左侧会显示 venv ,如下图所示。

1.4 PyTorch

直接在命令行窗口内运行:pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

1.5 C++ 生成工具

前往 https://visualstudio.microsoft.com/zh-hans/visual-cpp-build-tools/ 下载后运行,选择桌面 C++ 开发进行安装。

1.6 CUDA Toolkit

前往 https://developer.nvidia.com/cuda-toolkit-archive 下载12.6.3版本的 CUDA Toolkit ,按照默认设置安装。此处版本与上一步中 Pytorch 相对应,切勿安装其他版本。

1.7 Ninja

Ninja 用于加速其他依赖包的编译,运行 pip install ninja 即可。

1.8 项目依赖

此时终于准备好了全部的环境软件,运行 pip install -r requirements.txt 来安装项目本身的依赖。安装 flash_attn 耗时非常久且 CPU 满载属于正常现象,也可以自行安装预编译包。

1.9 huggingface-cli

最后一个安装的项目是 huggingface-cli ,用于下载模型。

pip install "huggingface_hub[cli]"

huggingface-cli download Wan-AI/Wan2.1-T2V-1.3B --local-dir ./Wan2.1-T2V-1.3B1.10 修改代码

使用 Python IDLE(安装 Python 时已附带)打开 Wan2.1 根目录下的 generate.py 文件,修改第387行(注意位置可能会变化),删除图中选中的部分后保存。

因 Windows 下文件名不允许包含星号,如不删除导出时会报错。

2.无提示词扩展运行

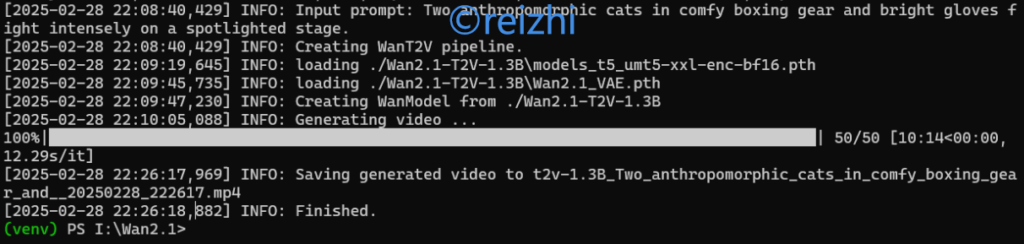

为了测试安装和运行情况,我们首先不加载提示词扩展(Prompt Extention)运行试试:

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --offload_model True --t5_cpu --sample_shift 8 --sample_guide_scale 6 --prompt "Two anthropomorphic cats in comfy boxing gear and bright gloves fight intensely on a spotlighted stage."根据硬件配置的不同,生成时间可能介于5-30分钟之间,视频文件最终会保存在 Wan2.1 文件夹下。此处官方有特别声明 1.3B 模型的训练数据有限,不建议生成 720P 分辨率。

3.带提示词扩展运行

提示词扩展的作用是使用 AI 帮我们扩写,以生成细节更丰富的画面。我们可以选择使用本地运行、调用 API 或者也可以不使用。这里以本地运行为例:

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --offload_model True --t5_cpu --sample_shift 8 --sample_guide_scale 6 --prompt "Two anthropomorphic cats in comfy boxing gear and bright gloves fight intensely on a spotlighted stage." --use_prompt_extend --prompt_extend_model Qwen/Qwen2.5-3B-Instruct首次使用本地提示词扩展会下载额外的千问模型,除了 3B 模型外也可以选择 7B 或者 14B 。

4.二次启动环境

首次部署完成后,二次启动环境就简单得多了:

I:

cd Wan2.1\venv\Scripts

activate.bat

cd ..\..